배경

클라우드 컴퓨팅의 확산, AI 기술의 성장 및 네트워크 클라우드화의 거대한 추세와 함께 더욱 광범위한 작업량으로 인해 데이터 센터는 인프라 규모 확장 압력을 받고 있습니다. 한 저명한 연구 기관에서 내부 요구사항과 연구 동기를 바탕으로 향후 인프라 제약을 예방하고자 솔루션을 모색했습니다. 기관은 데이터 센터를 구축/해체하지 않아도 생산 효율성을 증가시킬 수 있는 유연하고 확장할 수 있는 아키텍처 기반을 설계하고자 했습니다.

연구팀은 서로 다른 하드웨어 구성이 애플리케이션 성능에 영향을 미친다는 것을 발견했습니다. 따라서, 기관이 다양한 AI 워크로드 환경 요구사항에 대응하기 위해 유연한 구성형 인프라 시스템을 찾았습니다. 기관의 이론적인 개념은 프로세서, 가속기, 스토리지 및 네트워크 장치로 이루어져 있는 장치 풀에서 자원을 끌어와 여러 작업을 동시에 지원하는 것입니다. 이 프로젝트를 실현할 수 있는 파트너를 찾아 H3 플랫폼과 만나게 되었습니다. H3는 2014년도부터 PCIe 스위치 기술 연구 경력을 쌓아왔기 때문에 이 저명한 기관과 H3가 닿을 수 있었습니다.

챌린지

이러한 다중 서버 테스팅 표준 운영 절차는 시간이 너무 오래 걸립니다. 간단한 작업을 수행하기 위해 인력이 소모되고 머신 개수를 제한적으로 운용해야 합니다. 하지만 대기업에 걸맞은 프론트엔드 서비스 스케일 확장을 위해서는 이러한 제한적인 요소를 제거해야 합니다. H3는 테스트 절차의 효율을 증가시키는 것이 우선순위로 구성형 인프라 ODM을 진행하였습니다.

솔루션

일반적으로 서버에 고정된 가속기와 메모리가 할당됩니다. 서버는 작업량과 상관없이 할당된 자원으로 데이터를 처리합니다. 이러한 작업은 자원이 초과하거나 덜 할당되는 상황을 야기합니다. H3의 PCIe 스위치 기술은 독립적인 랙 타입 샤시에 모든 리소스를 풀링하는 아방가르드 개념을 이해하고 있습니다. 분리형 장치와 PCIe 연결을 통해 연산 서버에 동적 자원 분배를 하여 자원 낭비 문제를 해결합니다.

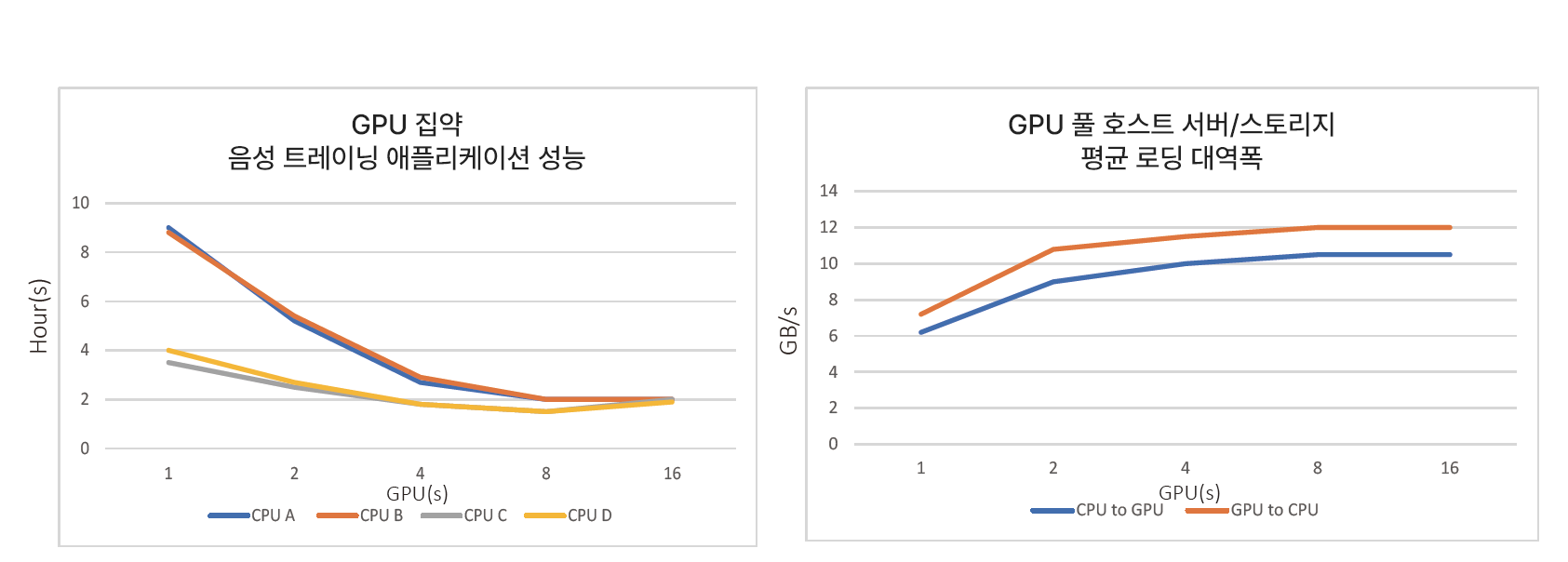

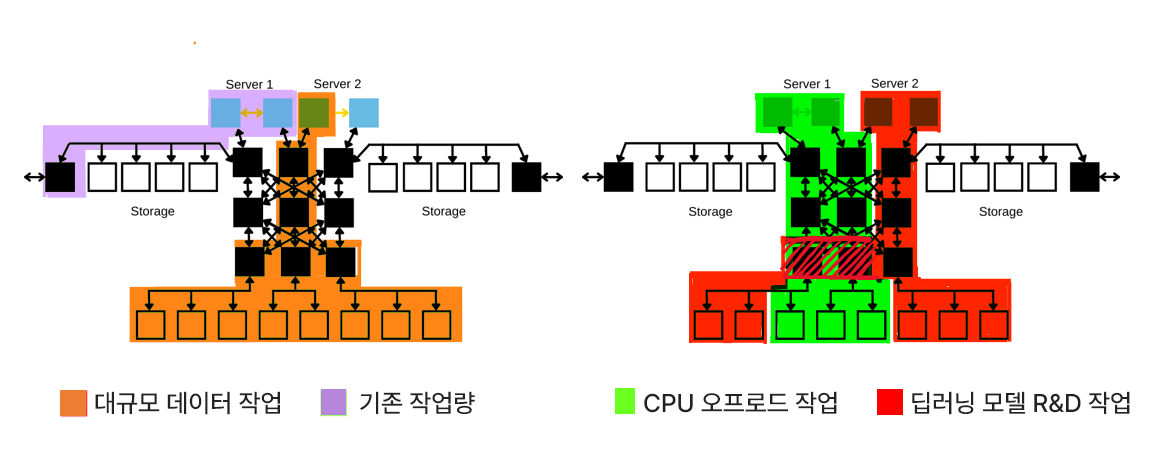

H3는 탄탄한 PCIe 스위치 기술 개발 경력을 기반으로 Broadcom PEX9797 스위치를 연결하여 장치 및 호스트 연결 레인 수(288 PCIe 3.0 레인)를 최대화하는 획기적인 발전을 이루었습니다. 새로운 랙 타입 인프라 설계는 가속기, 스토리지 및 네트워크 비폐성 공유로 기존 시스템의 성능을 능가합니다. 사용자가 필요한 만큼의 레인 수를 애플리케이션 대역폭 요구사항에 맞춰 할당할 수 있습니다. 연구팀은 기존 구성 환경에서 기기 간 연결 대역폭 포화 현상 (16GB/s) 때문에 병목 현상이 일어나 GPU를 얼마나 많이 장착하던 최대 GPU 4개 정도의 성능만 끌어낼 수 있었습니다 (그림1 참조). 고정 레인 수는 PCIe 스위치 기술로 인해 동적 레인 수 할당으로 대역폭을 늘리거나 줄여 GPU의 점감 성능 리턴을 해결하였습니다. 또한 자원을 구성형 인프라로 설계하여 작업량에 알맞게 동적으로 가속기의 자원을 서버로 분배하여 신속함과 유연성까지 더했습니다 (그림 2 참조).

그림 1

그림 2

결과

연구 보고서에 따르면, 이 연구는 구성형 시스템이 전체 성능에 미치는 다양한 요소 영향을 효과적으로 완충할 수 있음을 확인하였습니다. 연구원이 연구 논문에서 구성형 시스템의 유연성으로 AI 워크로드를 효율적으로 수행할 수 있다고 언급하여 H3의 전문성과 노력에 대한 인정을 받았습니다. 연구 논문을 성공적으로 마무리했을 뿐만 아니라, 이 연구팀은 그 이후 다양한 AI 워크로드를 실행하기 위해 구성형 인프라 솔루션을 지속적으로 채택했습니다. 이 연구팀과는 지금도 계속 거래를 하고 있으며 2세대 PCIe 구성형 시스템 및 관리 솔루션을 구매하였습니다.